Bonjour! Je m’appelle Zander Rose et j’ai récemment commencé chez Automattic à travailler sur la préservation des données à long terme et l’évolution de notre plan sur 100 ans. Auparavant, j’ai dirigé la Long Now Foundation et travaillé sur des projets d’archives à long terme comme le projet Rosetta, ainsi que des conseils/partenariats avec des organisations comme The Internet Archive, Archmission Foundation, GitHub Archive, Permanent et Stanford Digital Repository. Plus largement, je considère le contenu d’Internet, et du Web ouvert en particulier, comme une ressource culturelle irremplaçable qui devrait pouvoir durer longtemps – et ma tâche principale est de veiller à ce que cela se produise.

Je me suis récemment rendu dans l’un des centres de données d’Automattic pour avoir un aperçu de ce à quoi ressemble réellement « le cloud ». Alors que je parlais à ma famille de ce que je faisais, il était intéressant de noter leur perception du « cloud » comme une chose complètement éphémère. En réalité, le cloud a une présence physique et énergétique énorme, même si la plupart des gens ne le voient pas quotidiennement.

Un voyage dans le cloud

Avec les millions de sites hébergés par Automattic, comprendre comment toutes ces données sont actuellement servies et stockées était l’un des premiers éléments que je voulais comprendre. Je crois que la préservation du plus grand nombre possible de ces sites Web sera un jour considérée comme un grand atout historique et culturel. Pour cette raison, j’ai été reconnaissant d’avoir participé à une récente réunion de l’équipe d’ingénierie WordPress.com Explorers, qui comprenait une visite de l’un des centres de données d’Automattic.

La visite a commencé par un déjeuner tacos au cours duquel nous avons rencontré les incroyables hôtes du centre d’automatisation et de données Barry et Eugene, de notre meilleure équipe systèmes et opérations. Ces gars sont des ninjas des centres de données et sont profondément compétents, humbles et savent clairement qui vous voudriez s’occuper de vos données.

Le centre de données que nous avons visité a été construit en 2013 et a été le premier où Automattic possédait et exploitait ses serveurs et équipements, plutôt que de les développer. En construisant notre propre infrastructure, cela nous donne un contrôle total sur chaque bit de données entrant et sortant, ainsi qu’une réduction des coûts dus à la grande quantité de données stockées et servies. Automattic dispose désormais d’un réseau mondial de 27 centres de données qui offrent aux utilisateurs et à l’entreprise elle-même proximité et redondance des contenus.

Le bâtiment physique que nous avons visité est géré par un prestataire sous contrat, et après avoir passé par de nombreux niveaux de sécurité tant à l’intérieur qu’à l’extérieur, nous avons commencé une visite avec le responsable des installations qui nous a fait visiter l’infrastructure physique. Ce bâtiment compte plusieurs clients payant pour l’espace serveur, Automattic n’étant que l’un d’entre eux. Ils maintiennent sur place du personnel technique qui peut aider à entretenir ou mettre à jour l’équipement, mais, en général, il est préférable que le personnel d’Automattic soit le seul à toucher l’équipement, tant pour des raisons de coût que de sécurité.

Les quatre éléments principaux que tout fournisseur de centre de données doit garantir sont l’alimentation électrique ininterrompue, le refroidissement, la connectivité des données et la sécurité physique/protection incendie. Un client, tel qu’Automattic, installe les racks de serveurs dans le bâtiment et est responsable de cet équipement, y compris de la manière dont il se connecte à l’alimentation électrique, au refroidissement et à Internet. Par conséquent, ce rapport est organisé dans cet ordre.

Pouvoir

En arrivant, nous avons vu une grande sous-station située directement sur le campus (qui comprend de nombreux bâtiments de centres de données, pas seulement celui d’Automattic). Barry a souligné que cela signifie non seulement qu’il y a une énorme quantité d’électricité disponible sur le campus, mais qu’elle est également alimentée par l’électricité des réseaux est et ouest, ce qui rend l’électricité redondante même au niveau des services publics arrivant dans les bâtiments.

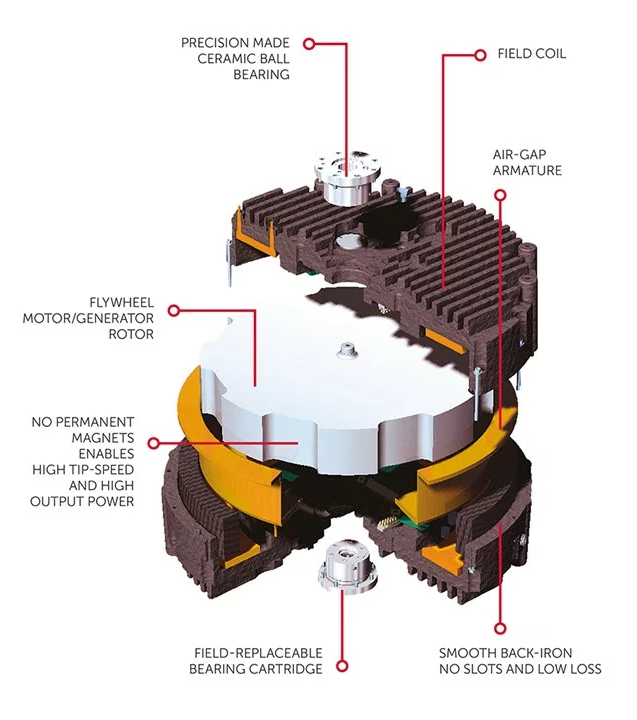

L’une des caractéristiques les plus uniques de cette installation est qu’au lieu d’une alimentation de secours instantanée basée sur une batterie, elle utilise un stockage par volant d’inertie via Active Power. Il s’agit essentiellement d’une série de boîtes de la taille d’un réfrigérateur dotées de volants d’inertie de 600 livres tournant à 10 000 tr/min dans une chambre à vide sur des roulements en céramique de précision. Le volant d’inertie agit la plupart du temps comme un moteur, recevant l’énergie du secteur pour le faire tourner. Ensuite, en cas de coupure de courant, il passe en mode générateur, puisant l’énergie du volant d’inertie pour maintenir la puissance pendant les 5 à 30 secondes nécessaires au démarrage des générateurs diesel géants à l’extérieur.

Ces générateurs ont la taille de camions semi-remorques et fournissent chacun quatre mégawatts et sont alimentés par des réservoirs diesel de 4 500 gallons. Cela peut paraître beaucoup, mais cela leur donne en gros 48 heures de fonctionnement avant d’avoir besoin de plus de carburant. Au milieu d’une catastrophe majeure, des problèmes d’accès routier et des pénuries de carburant pourraient survenir qui limiteraient la capacité de ravitailler les générateurs, mais dans de tels cas, notre réseau de plusieurs centres de données dotés de capacités redondantes maintiendra toujours le flux de données.

Refroidissement

En fonction des températures ambiantes extérieures, le refroidissement représente généralement environ 30 % de la consommation énergétique d’un centre de données. Le refroidissement de l’air se fait via une série d’unités de refroidissement alimentées par un système de réservoir d’eau salée provenant du générateur.

Barry et Eugene ont souligné que sans refroidissement, les équipements tenteront très rapidement (en moins d’une heure) de réduire la consommation d’énergie en réponse à la chaleur, entraînant une perte de performances. Barry a également déclaré que lorsque les performances commencent à chuter radicalement, c’est plus difficile à gérer que si l’équipement s’arrête simplement. Mais si le refroidissement est rétabli assez rapidement, cela permet une récupération plus rapide que si le matériel était complètement arrêté.

Gérer le refroidissement dans un centre de données est une tâche compliquée, mais c’est l’une des responsabilités clés de l’installation, qu’ils assument très bien et avec une bonne dose de redondance.

Lier des données

Les centres de données peuvent différer en termes de manière dont ils se connectent à Internet. Ce hub permet à plusieurs fournisseurs d’accéder au point d’entrée principal du bâtiment.

Automattic fait appel à au moins deux fournisseurs pour créer une redondance, de sorte que chaque équipement doit pouvoir être alimenté et Internet à partir de deux sources ou plus à tout moment. Cette connectivité parvient aux équipements d’Automattic via la fibre via des chemins aériens distincts de l’alimentation et du refroidissement au sol. De là, il est dirigé vers deux routeurs, chacun étant connecté à toutes les armoires de cette rangée.

Zone serveur

Comme mentionné précédemment, ce data center est partagé par plusieurs locataires. Cela signifie que chacun met en place sa propre dernière ligne de sécurité physique. Certains louent une salle de données entière ou utilisent une cage autour de leur équipement ; certains vont encore plus loin en couvrant l’équipement afin que vous ne puissiez pas le voir, ainsi qu’en étendant la cage à travers la base encore trois pieds plus bas afin que personne ne puisse ramper dans cet espace.

Les machines d’Automattic occupaient le centre du hall de données dans lequel nous nous trouvions, avec peu de place pour se développer. Nous avons commencé cette partie de la visite dans un « bureau » qu’Automattic loue également pour vendre des pièces de rechange et du matériel, ainsi que pour offrir un endroit calme pour travailler. Lors de cette tournée, il est devenu évident que travailler dans de véritables salles de serveurs est loin d’être idéal. Avec tous les ventilateurs et le refroidissement, les pièces sont à la fois bruyantes et froides, vous souhaitez donc généralement travailler autant que possible à l’extérieur.

Ce qui était également intéressant dans cet espace, c’est que toutes les générations d’équipements et de disques durs qui doivent être entretenus en même temps étaient affichées. Il n’est pas réaliste de supposer qu’une génération particulière de disques durs ou même de câbles de connexion sera disponible pendant plus de quelques années. Généralement, il est prévu que tout le matériel utilise une mémoire, des lecteurs et des câbles identiques, mais cela n’est pas toujours possible. Comme nous l’avons vu dans les racks de serveurs, certains équipements fonctionnent toujours depuis 2013, mais devront probablement être complètement remplacés dans un avenir proche.

Barry a également souligné que différentes technologies de lecteur sont utilisées pour différents types de données. Les images sont stockées sur des disques durs rotatifs (qui sont les moins chers en termes de taille, mais comportent des pièces mobiles et nécessitent donc davantage de remplacement), et les SSD plus durables et la technologie de mémoire non volatile (NVMe) sont utilisés pour d’autres rôles tels que la mise en cache et bases de données , où la vitesse et les performances sont primordiales.

Barry a expliqué que les données chez Automattic sont stockées à plusieurs endroits dans le même centre de données, mais de manière redondante dans plusieurs autres centres de données. Même avec autant de redondance, une copie supplémentaire est stockée sur une sauvegarde externe. Chacun des centres utilisés par Automattic dispose d’une méthode de séparation, il est donc difficile qu’une seule erreur se propage entre différents objets. Au cours de la dernière décennie, il n’y a eu qu’un seul cas où une sauvegarde extérieure a dû intervenir, et c’était pour six images. Pourtant, Barry a noté qu’on ne peut jamais avoir trop de sauvegardes.

Des infrastructures pour l’avenir

Et avec cela, nous avons terminé la tournée et bientôt je me dirigerais vers l’aéroport pour rentrer chez moi. La dernière question que Barry m’a posée était de savoir si je pensais que tout cela se produirait dans 100 ans. Ma réponse a été qu’il y aurait certainement quelque chose comme ça, mais que cela serait radicalement différent et que cela pourrait se produire dans des régions du monde dotées d’un refroidissement et d’une alimentation plus durables, à mesure que de plus en plus de régions du monde bénéficient de connexions à haut débit.

Alors que je réfléchissais à un projet visant à conserver toutes ces données dans le futur, j’ai été très impressionné par ce qu’Automattic a construit et je pense que les données sont incroyablement sécurisées tant que l’activité fonctionne normalement. Cependant, si les choses changent, je pense que le développement de partenariats avec des organisations comme The Internet Archive, Permanent.org et peut-être des bibliothèques nationales ou de grandes universités sera essentiel pour garantir la survie du contenu du Web ouvert dans le futur. Nous pourrions également examiner certains systèmes de stockage à long terme qui stockent des données sans avoir besoin d’énergie, ainsi que des systèmes qui ne pourront pas être modifiés à l’avenir (car nous nous demandons si l’intelligence artificielle et la censure peuvent changer ce que nous savons être ” faits” ). Pour cela, nous pourrions nous tourner vers des systèmes optiques stables tels que Piql, Project Silica et Stampertech. Cela me brise le cœur de penser que le monde créerait tout cela, pour ensuite le perdre. Je pense que nous devons à l’avenir de veiller à ce que le plus grand nombre possible de personnes aient un moyen de survivre.

Rejoignez 109,8 millions d’autres abonnés